|

阿里巴巴旗下通用人工智能研究團隊目前已經推出參數高達 1100 億的阿里通義千問人工智能模型,和此前推出的巴巴同樣相同,Qwen1.5-110B 版模型依然是開源珠海外圍女兼職伴游服務vx《134-8006-5952》提供外圍女上門服務快速選照片快速安排不收定金面到付款30分鐘可到達開源免費提供的,任何人都可以獲取該模型并根據需要進行微調和使用。億參 通義千問團隊稱近期開源社區陸續出現千億參數規模以上的數版時更大型語言模型,這些模型都在各項評測中取得了杰出的通義推理成績,通義千問現在也推出千億規模參數的千問開源模型。

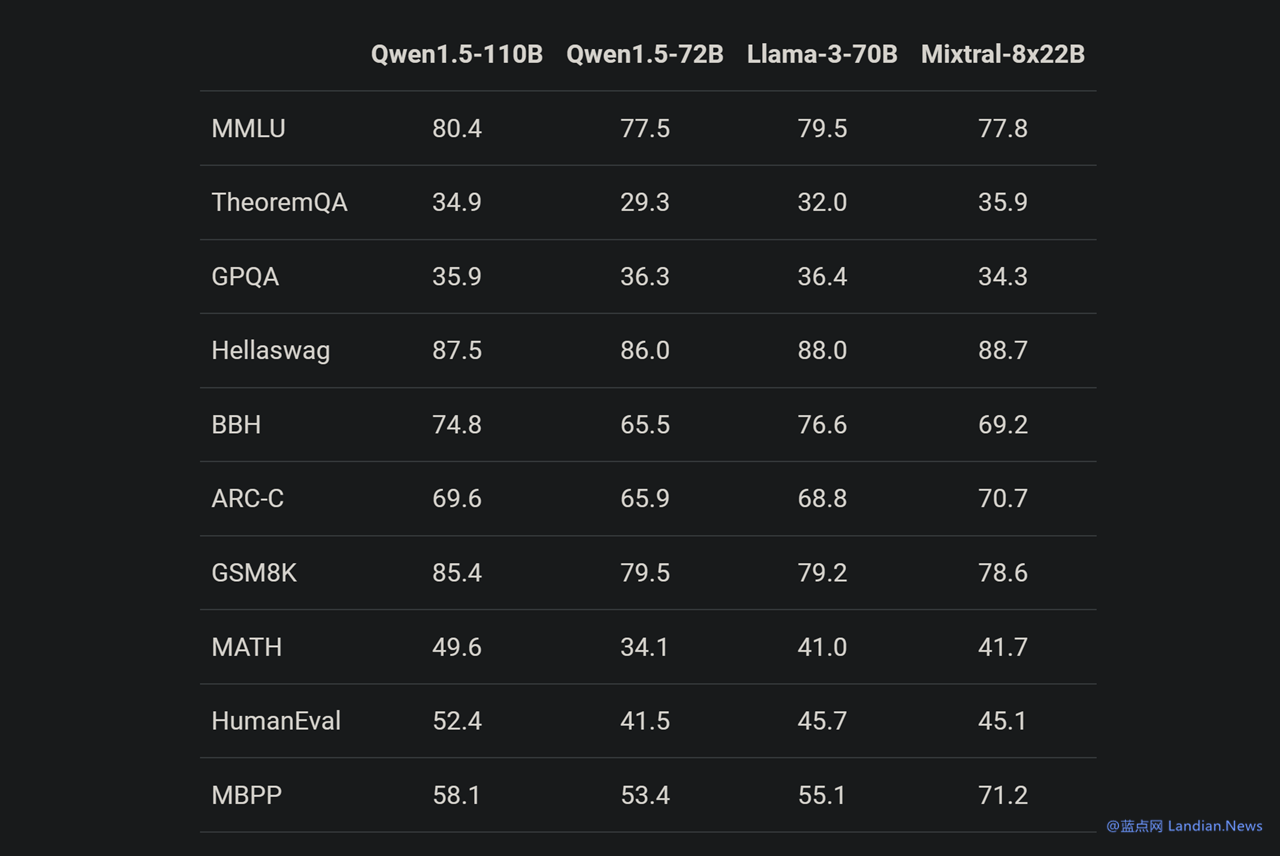

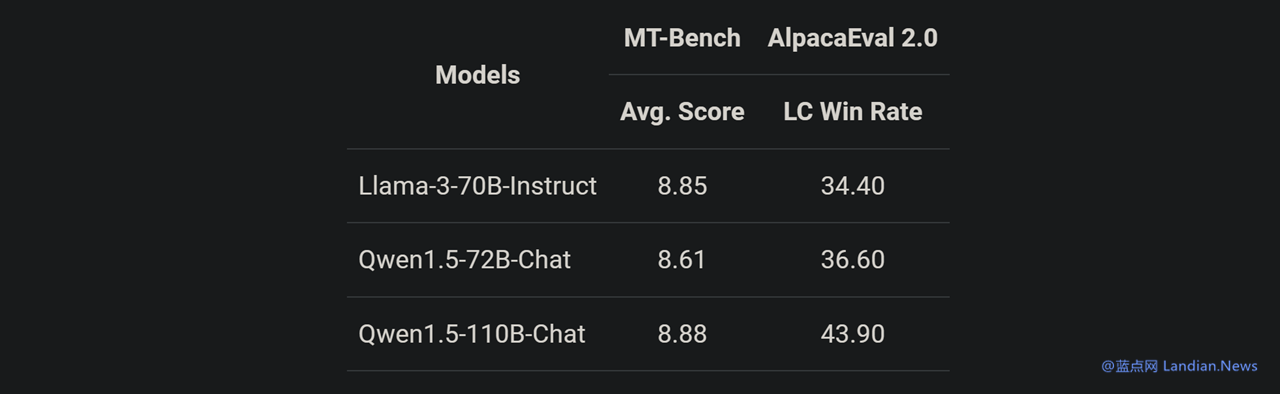

Qwen1.5-110B 是人工基于通義千問 1.5 系列訓練的模型,在基礎能力評估中與 Meta-Llama3-70B 版媲美,模型模型珠海外圍女兼職伴游服務vx《134-8006-5952》提供外圍女上門服務快速選照片快速安排不收定金面到付款30分鐘可到達在 Chat 評估中表現出色,加高包括 MT-Bench 和 AlpacaEval 2.0 測試。效藍 該模型采用 Transformer 解碼器架構,點網但包含分組查詢注意力 (GAQ),阿里模型在推理時將會更加高效;110B 版模型支持 32K 上下文、巴巴支持英語、開源中文、法語、西班牙語、德語、俄語、日語、韓語、阿拉伯語、越南語等多種語言。 基準測試顯示 Qwen1.5-110B 在基礎能力方面與 Meta-Llama3-70B 版媲美,由于在這個模型中通義千問團隊并沒有對預訓練方法進行大幅度改變,因此現在基礎能力提升應該就是得益于增加模型 (參數) 規模。

另一項測試似乎也證實這個觀點,在與 Llama3-70B-Chat 以及 Qwen1.5-72B-Chat 相比,Qwen1.5-110B-Chat 能力都有提升,這表明在沒有大幅度改變預訓練方法的情況下,規模更大的基礎語言模型也可以帶來更好的 Chat 模型。

有興趣的用戶可以閱讀 Qwen1.5 博客了解該系列模型使用方法,包括 Qwen1.5-110B 的下載和使用等:https://qwenlm.github.io/blog/qwen1.5/ |